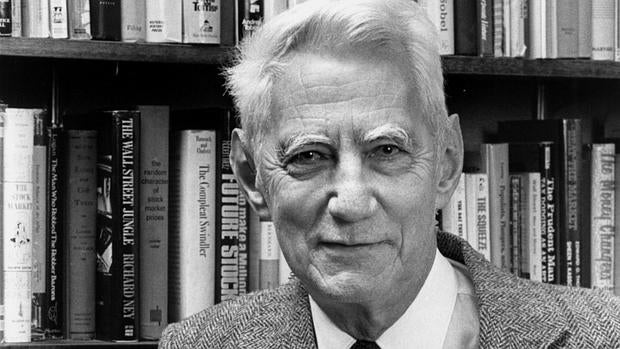

Claude Shannon, el hombre que atrapó la información

Se cumple el centenario del nacimiento del ingeniero americano que dio un giro a los sistemas para transmitir datos

Los métodos de información hoy serían diferentes sin Claude Shannon. El ingeniero electrónico y matemático estadounidense desarrolló un método para expresar la información de forma cualitativa, a base de mejorar las formas de transmisión de la información , tanto mediante el flujo a través de hilos o cables como el aéreo, por medio de corrientes eléctricas fluctuantes.

Claude Shannon pasó los primeros años de su vida en Gaylord, donde se graduó. Demostró desde bien joven un interés especial por las cosas mecánicas y resaltaba por encima de sus compañeros en las asignaturas de ciencias, lo que le llevó a desarrollar su carrera en ese ámbito. Tenía a Edison como referente y trató de acercarse lo máximo que pudo a sus investigaciones.

Estudió en la univesidad de Michigan, donde obtuvo los títulos de ingeniero electricista y matemático. Durante los estudios, comenzó a trabajar como asistente de investigación en el departamento de ingeniería eléctrica en el Instituto Tecnológico de Massachusetts (MIT). Allí tuvo contacto con el ordenador analógico más avanzado del momento, el Differential Analyzer de Vannevar Bush.

Fue en ese periodo cuando surgió el interés de Claude Shannon por los circuitos de reveladores complejos. Al trabajar con las centralitas telefónicas de relés, se dio cuenta de que podían utilizarse para hacer cálculos y desarrolló esa idea usando la lógica y el álgebra booleana durante su estancia en los laboratorios Bell de Nueva York.

En esa época, tocó muchas áreas, aunque la más notable fue la teoría de la información, materia sobre la que publicó sus estudios en 1948 con el nombre de «Una teoría matemática de la comunicación» . Ahí demostraba que todas las fuentes de la información existentes pueden medirse y que los canales de comunicación que usan tienen una unidad de medida similar, determinando la velocidad máxima de transferencia o capacidad de canal.

Demostró también que la información se puede transmitir sobre un canal, pero solo si la magnitud de la fuente no excede la capacidad de transmisión del canal. Sentó las bases, además, para la corrección de errores, supresión de ruidos y redundancia.